PME ou Grand Groupe : faut-il créer son propre LLM ?

Guide IA pour dirigeant innovant (Partie #2)

Le choix de modèle et d’hébergement est déterminé principalement par le type de tâche à réaliser, les capacités financières de l’entreprise, les besoins de customisation du modèle et les contraintes de confidentialité des données.

Coût et complexité de l’hébergement interne

Les trois principaux scénarios d’hébergement sont :

- Appeler les API de modèles LLM ou utiliser des solutions IA sur étagère pour des tâches précises, ce qui suffira dans la plupart des cas

—> Exemple : GPT, ou M365 Copilot de Microsoft - Se tourner vers des modèles open source plus petits, qui demandent peu d’efforts de fine-tuning

—> Exemple : LLAMA, modèle open source de Meta, dont la v2 (entraînée sur 2 trillions de tokens) est gratuite pour la recherche comme les usages commerciaux - Créer et héberger ses propres modèles dans des environnements sécurisés et privés, pour faire face à des enjeux de sécurité de premier plan ou pour procéder à des customisations très particulières

—> Exemple : Azure OpenAI chez Microsoft, qui donne accès aux modèles IA (GPT-4, GPT-3, Codex, DALL-E) en garantissant la sécurité et la “promesse entreprise” d’Azure

La demande de serveurs dotés de matériel spécialisé pour l'entraînement de modèles d'IA est en forte croissance, et les serveurs dopés avec des accélérateurs GPU sont très chers (le DGX H100 de Nvidia coûte par exemple à 482 000$ HT avec 8 GPU). Si elles ne possèdent pas leurs propres machines, les entreprises souhaitant exécuter et héberger leur modèle s’appuient sur des fournisseurs cloud comme AWS, Microsoft Azure, ou Google Cloud, mais peuvent être confrontés à des problèmes de disponibilité de GPU.

Alors que construire et héberger son propre LLM est extrêmement coûteux, de nombreux résultats peuvent être atteints avec du prompt engineering uniquement (rédiger des instructions spécifiques en s’adressant à l’IA pour obtenir de meilleurs résultats).

Les acteurs comme OpenAI facturent généralement en fonction de 2 éléments : le coût du prompt (dépend du nombre de tokens utilisés pour introduire le contexte et donner une instruction) et le coût de réponse (dépend du nombre de tokens que l'API renvoie en tant que réponse). Plus le nombre de documents partagés à l'API est élevé, plus le coût peut devenir important.

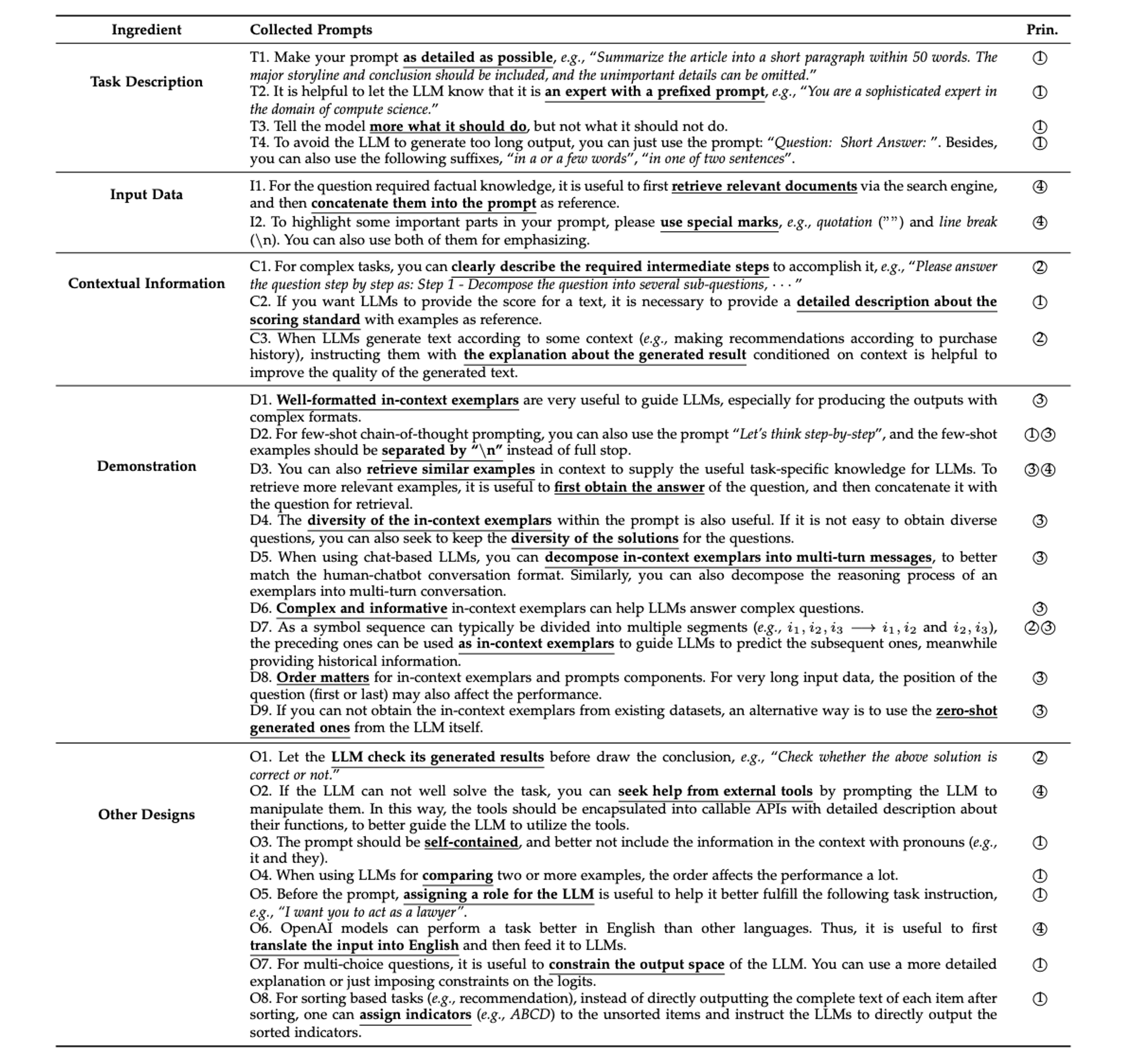

Principes et recommandations pour le prompt engineering (Kun Zhou, 2023)

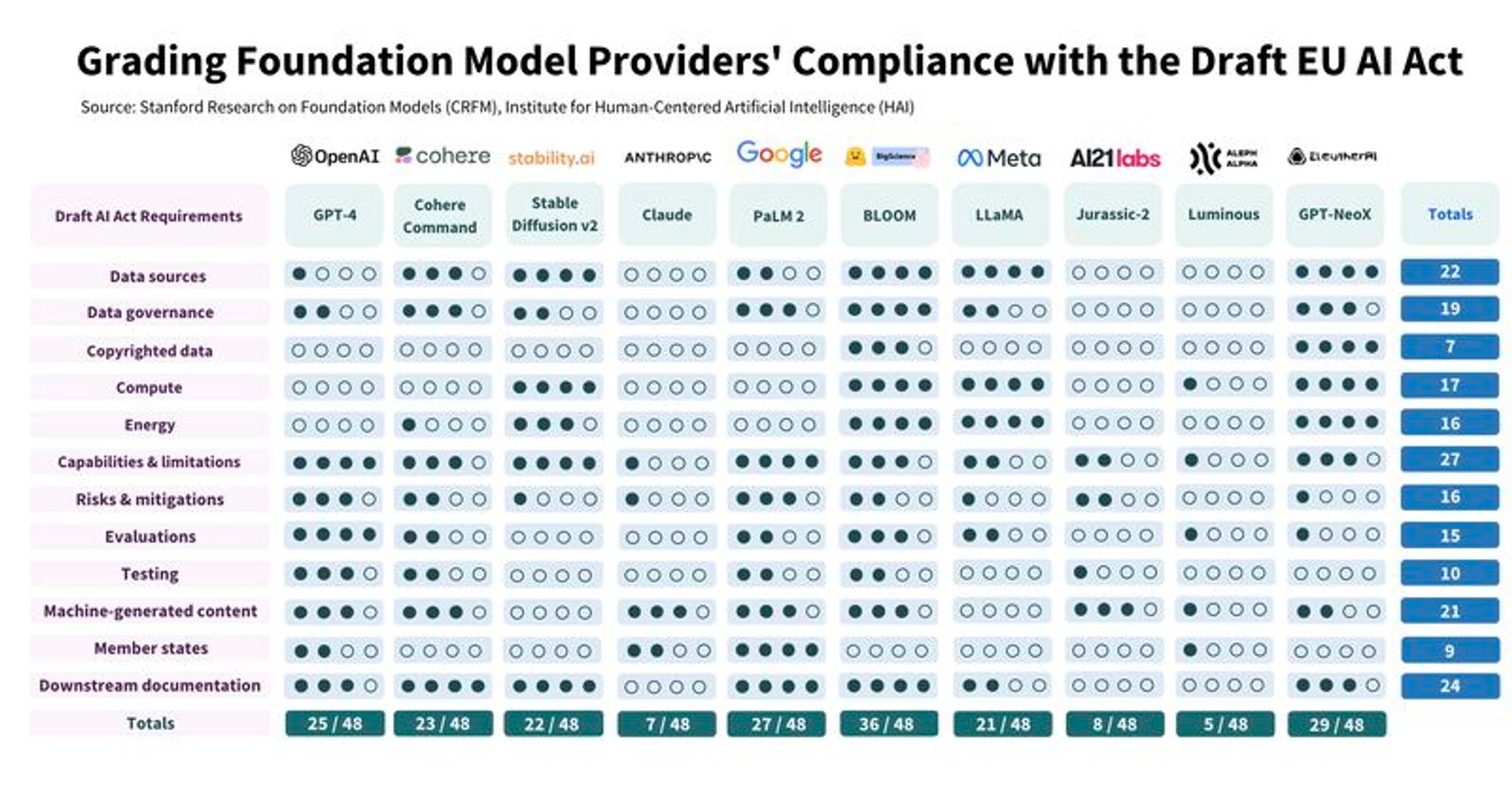

Quant au choix du modèle, s’il faut prendre en compte sa performance et son efficacité (un plus petit modèle entrainé sur un cas spécifique sera souvent plus pertinent sur ce cas qu’un modèle très large), il devra aussi prendre en compte le cadre réglementaire. Des chercheurs de Stanford ont évalué 10 modèles d'IA sur 12 critères correspondant à des exigences de l'AI Act. Bilan : aucun n'est conforme à la future réglementation européenne.

Conformité des principaux Foundation Models avec les exigences annoncées de l’AI Act (Stanford, 2023)

Intégration de vos connaissances métiers

Dans de nombreux cas, les entreprises doivent customiser le modèle à leur propre contexte (langage spécifique, processus métiers, knowledge management).

Trois méthodes permettent d’entrainer un modèle, la meilleure approche consistant à trouver le bon équilibre entre qualité des résultats et coûts selon le contexte :

- Entrainement en partant de rien : s’il est nécessaire de changer significativement la structure du modèle (par exemple le nombre de dimensions cachées ou la taille du vocabulaire), c’est un processus long et coûteux.

- Fine-tuning : la plupart du temps, le fine-tuning (injecter dans un modèle existant des connaissances qu’il ne possède pas pour obtenir des réponses plus adaptées) permet d’améliorer les performances d’un LLM. On part d'un modèle pré-entraîné et on affine l’entrainement avec les données de l’entreprise. Sur des tâches spécifiques, le fine-tuning de modèles open-source (donc gratuits) peut apporter des résultats similaires (et parfois meilleurs) que les modèles commerciaux.

- Prompt-tuning : comme évoqué plus haut, on part d’un modèle et on lui fournit des instructions spécifiques ainsi que du contenu, en lui demandant de répondre aux instructions sur la base de ce contenu. Dans de nombreux cas d’usages, un bon prompt sera suffisant pour obtenir des résultats satisfaisants.

Estimations des coûts de fine-tuning du modèle Curie (Truefoundry)

Le retrieval-augmented generation (RAG) est de plus en plus utilisé pour exploiter un modèle comme GPT avec des données personnalisées : tous les documents sont indexés dans une base de données vectorielle, et le framework LangChain, qui permet d’interagir avec l’IA, aide les développeurs à créer des applications utilisant des LLM.

L’utilisation correcte des bases de données vectorielles peut entraîner des économies importantes par rapport aux nombreux appels d'API aux modèles de base, pour de très bons résultats. Safran a par exemple créé une interface conversationnelle répondant à toutes les questions des employés, connectée en temps réel à l'intranet, à l'ERP et au PLM.

Photo issue d’une conférence de Raouf Chebri, Developer Advocate chez Neondatabase (je l’ai très mal cadrée)

Confidentialité des données

L’usage des LLM dépend beaucoup des besoins de confidentialité des données. Le sujet est encore très ouvert, mais de premières grilles de lectures apparaissent :

- Le secteur d’activité : les enjeux de confidentialité diffèrent selon le type de données manipulées, et les règlementations ne sont pas les mêmes (PDIS, SOC, ISO...). Dans des secteurs très sensibles, tels que la défense ou la santé, une attention toute particulière devrait être portée à la protection des données.

- Les coûts : seules les grandes entreprises seront financièrement capables de créer et d’héberger leurs propres instances dans des environnements sécurisés et privés.

- L’usage : certains modèles sont figés (utilisés uniquement pour répondre aux questions des utilisateurs) et permettent de mieux protéger les données, quand d’autres s’appuient sur les données partagées par les utilisateurs pour s’entraîner et entrainent des risques de confidentialité.

Finalement, le plus simple est souvent le mieux

L'approche d'hébergement devra être décidée au cas par cas, selon le type d'utilisateurs et de données partagées, en trouvant le bon barycentre entre coûts d'opérabilité et gestion des risques. Des questions complémentaires pourront permettre d'affiner la stratégie :- L'entreprise a-t-elle l'IA comme coeur d'activité ?

- L'entreprise a-t-elle besoin de modifier lourdement les LLMs en question ?

- De quel business-unit parle-t-on ? (toutes les business units n'auront pas les même besoin)

- Quel est le niveau d'urgence du projet ?

- Quel est le niveau d'incertitude dans le projet ?

- Quelles sont les ressources disponibles ?

Il n'y a pas de recette toute faite, mais les solutions les plus simples seront souvent les meilleures. En d'autres termes, s'il n'y a pas d'enjeu de confidentialité ni de besoin de customisation, GPT couplé à du prompting suffira à résoudre de nombreux problèmes. Des modèles hybrides sont également envisageables.

Sources

- David Patterson, Joseph Gonzalez, Quoc Le, Chen Liang, Lluis-Miquel Munguia, Daniel Rothchild, David So, Maud Texier, Jeff Dean (2021) Carbon Emissions and Large Neural Network Training

- Wayne Xin Zhao, Kun Zhou, Junyi Li, Tianyi Tang, Xiaolei Wang, Yupeng Hou, Yingqian Min, Beichen Zhang, Junjie Zhang, Zican Dong, Yifan Du, Chen Yang, Yushuo Chen, Zhipeng Chen, Jinhao Jiang, Ruiyang Ren, Yifan Li, Xinyu Tang, Zikang Liu, Peiyu Liu, Jian-Yun Nie, Ji-Rong Wen (2023) A Survey of Large Language Models

- Edward J. Hu, Yelong Shen, Phillip Wallis, Zeyuan Allen-Zhu, Yuanzhi Li, Shean Wang, Lu Wang, & Weizhu Chen. (2021). LoRA: Low-Rank Adaptation of Large Language Models

- EU AI Act

- Hugging Face Blog - LoRA

- Stratus adopte les Xeon Cascade Lake sur ses Edge ftServer

- Train a Language Model from Scratch

- Economics of Large Language Models

- Microsoft Azure - OpenAI Overview