Ce qu’on oublie (encore) dans les comités d’investissement IA

Le billet de Victor

Dérisquez

Planifiez un échange avec un expert en IA pour vous aider à atteindre vos objectifs

Introduction – Pourquoi les boards survolent encore la courbe d’apprentissage

Depuis la démocratisation des grands modèles de langage (LLM), on ne compte plus les pitch-decks qui promettent de « révolutionner » un secteur grâce à l’IA générative. Pourtant, côté comité d’investissement, la discussion reste souvent cantonnée aux mêmes réflexes : quel GPU acheter ? quelle taille de modèle ? quelle part de données propriétaires ? Autrement dit : la technique avant le pourquoi et le comment.

Chez Kayro, nous accompagnons fonds et entreprises dans la structuration de leurs produits IA. Notre conviction : la majorité des échecs ne provient ni d’un manque de puissance de calcul ni d’un mauvais choix de modèle, mais d’une incompréhension des mécanismes internes qui conditionnent la valeur livrée à l’utilisateur final. Les quatre points ci-dessous devraient être placés en haut de la to-do list de tout board qui veut passer de la hype aux résultats.

1. Un LLM est probabiliste, pas déterministe

Dans un logiciel classique, l’addition 2+5 renvoie toujours 7.

Dans un LLM, la génération d’une phrase dépend :

- de la stochasticité : un simple

temperature > 0transforme la sortie en meilleure hypothèse, jamais en vérité absolue ; - du prompt : une virgule déplacée ou une variable mal typée altère tout l’espace de probabilité.

Pourquoi ça compte côté invest ?

- Governance : si les prompts ne sont pas versionnés, on ne peut pas auditer la production.

- Unit economics : un agent mal paramétré tournera en boucle, facturera plus de tokens et alourdira la note cloud.

Le prompt n’est pas une question : c’est une unité de code qui se teste, se loge dans un repo et se monitor comme n’importe quel micro-service. D'autant qu'écrire une séquence de prompts API parfaite — avec ses variables, son routage et toute la logique d’appel d’outils — est bien plus exigeant que d’itérer pas-à-pas dans l’interface chat : on y dépose des exemples, on corrige à la volée, on voit le résultat instantanément. Autrement dit, la phase conversationnelle facilite l’exploration, tandis que l’API exécute ce workflow rigide.

2. La context window : une mémoire de travail éphémère

Parler de « mémoire » prête à confusion. La context window n’est ni la RAM ni une base vectorielle ; c’est un buffer séquentiel qui héberge, l’espace de quelques millisecondes, tout ce dont le modèle a besoin pour raisonner :

Si votre spec tient en une ligne ⇒ problème sous-spécifié et réponse générique ; si elle tient en 20k tokens, c’est un problème d’ingénieure, il faut segmenter. Pourquoi ça compte côté invest ?

- Time-to-value : si le cas d’usage est sous-spécifié, l’utilisateur n’aura jamais de ROI ; le produit sera abandonné avant la Série A.

- Scalabilité : trois prompts bien architecturés coûtent moins cher qu’un giga-prompt mal pensé.

Quand aux systèmes multi-agents, ils sont très intéressants, parfois même bluffants, mais difficiles à maitriser. D'expérience, ils ne sont nécessaires que dans très peu de cas d'usages.

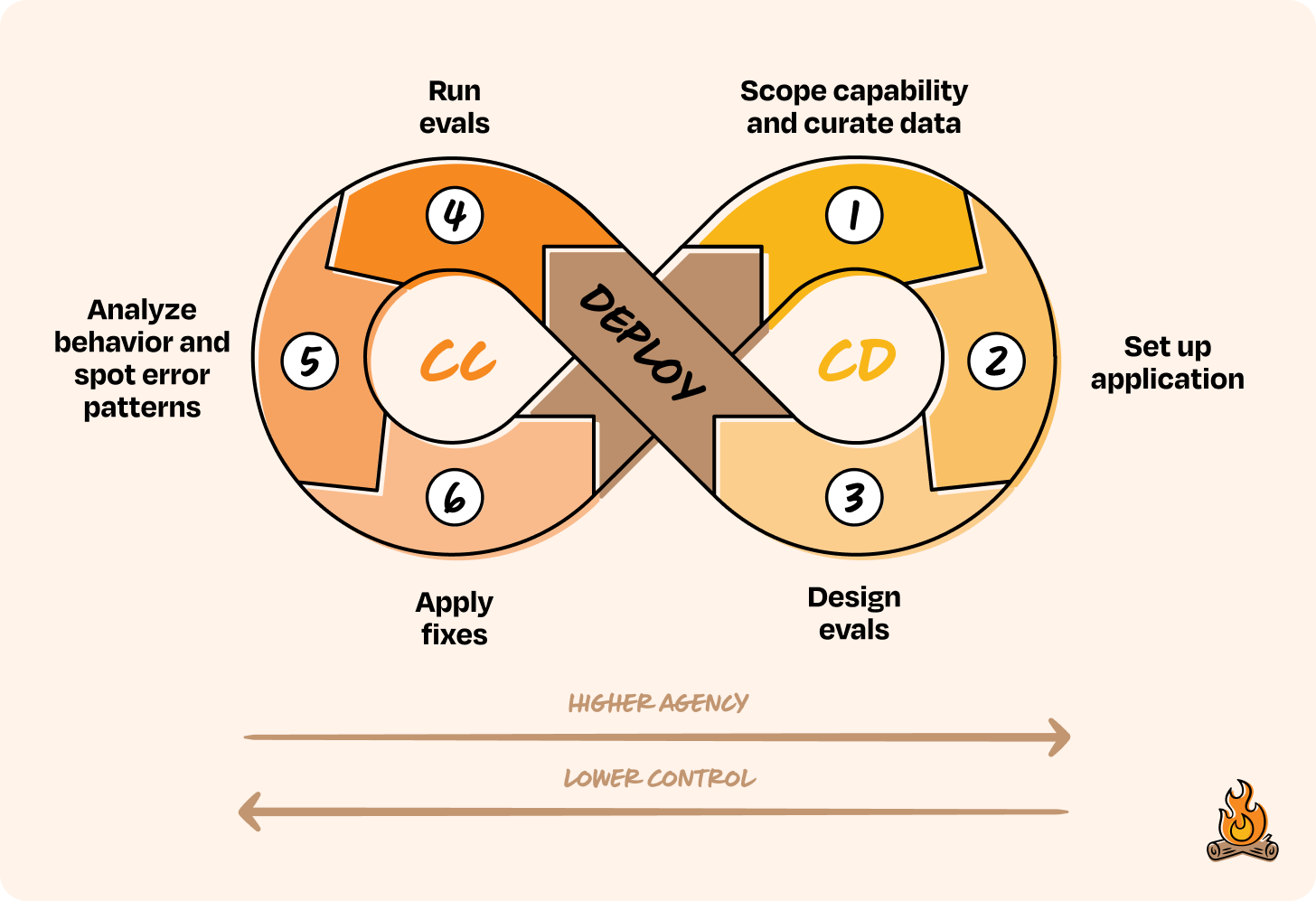

3. Pas de boucle de feedback, pas de moat

Un LLM « vanilla » n’épouse pas votre jargon fiscal ou vos KPI métier par magie. Pour converger :

- Collecte des retours utilisateurs (notes, clics, corrections).

- Annotation (humains ou modèles spécialisés).

- EvalOps : hallucination rate, coût par token, CSAT, etc.

- Amélioration continue (fine-tuning, RAG, prompt engineering).

Pourquoi ça compte côté invest ?

- Barrière à l’entrée : la donnée annotée est difficile à reproduire, elle constitue l’avantage défendable.

- Valorisation long terme : un pipeline de feedback robuste rassure sur la capacité à itérer rapidement.

4. Le coût d’inférence explose… ou pas

Si vous êtes encore en train de choisir votre infra GPU avant de cadrer vos cas d’usage : on peut en parler. Pourquoi ça compte côté invest ?

- TCO : dans 80 % des business cases early-stage, l’API garde l’avantage économique.

- Focus : optimiser des GPU n’est pas le cœur d’un produit, apprendre du marché, si.

Conclusion – Le bon KPI : vitesse d’apprentissage

Les LLM ne sont ni des oracles ni des boîtes noires magiques ; ce sont des moteurs d’hypothèses. Leur valeur dépend :

- De la précision du contexte injecté ;

- De la rapidité de la boucle feedback → ajustement ;

- De la discipline produit autour du prompt et de l’observabilité.

Le prochain champion ne sera pas celui qui détient la plus grosse ferme de GPU (quoi que ?), mais celui qui transforme chaque token en insight métier avant ses concurrents.

Question à poser au prochain board : « Quel flux IA peux-je mettre en production cette semaine pour générer un ROI mesurable – financier, stratégique ou humain ? »

Tout le reste n’est, littéralement, qu’architecture.

Envie de continuer votre lecture ?

Prêt à innover ?

Contactez-nous pour découvrir comment notre expertise en IA peut transformer votre entreprise