Carnet de culture ML

Simplifier les concepts clés du Machine Learning

Dérisquez

Planifiez un échange avec un expert en IA pour vous aider à atteindre vos objectifs

Bienvenue sur votre carnet de culture en Machine Learning

Vous travaillez avec des Data Scientists, ML Engineers ou Data Engineers ?

Et vous souhaitez mieux comprendre les notions qu’ils utilisent.

Ce guide simplifie les concepts clés du Machine Learning.

Partagez-le avec vos collègues si vous le trouvez utile. Un savoir partagé, c’est une entreprise qui avance plus vite !

1. Comprendre les algorithmes simples

Objectif : Explorer les algorithmes simples pour prédire ou classifier les données.

Régression & classification linéaire

- Régression :

- Prédire un nombre (ex. : estimer la température du lendemain en fonction des conditions météorologiques actuelles..).

- On trace une droite pour expliquer la relation entre les données d’entrée et la sortie.

- Classification :

- Prédire une catégorie (ex. : spam ou pas spam).

- La méthode essaye de séparer les données dans différentes zones en fonction de leurs caractéristiques (par exemple : tracer une ligne séparant deux groupes).

SVM (Support Vector Machine)

- Une méthode pour classifier ou prédire, qui trouve la meilleure séparation possible entre deux groupes de données en maximisant la distance entre les points les plus proches et la ligne/frontière de séparation.

- Les SVM fonctionnent comme un classificateur, par exemple, pour distinguer les e-mails "spam" et "non-spam" en traçant une frontière entre eux.

Apprentissage bayésien

- Basé sur les probabilités, il ajuste les prédictions en fonction des informations préexistantes (appelées "a priori") et des nouvelles données qu'on observe.

- Exemple : Si 90 % des mails avec "URGENT" sont du spam, ce modèle le prend en compte pour améliorer la détection.

Méthodes à noyaux

- Permettent de travailler dans des espaces plus complexes en projetant les données dans une dimension supérieure.

- Exemple : Transformer des données en 2D pour séparer des clusters qui semblent mélangés.

2. Clustering et découverte de groupes

Objectif : Apprendre à regrouper les données sans supervision.

Algorithme EM (Expectation-Maximization)

- Une méthode pour trouver des structures cachées dans des données, même si on n'a pas toutes les infos.

- Exemple : Deviner les préférences d'utilisateurs similaires sur Netflix selon leur comportement pour personnaliser leur feed, sans connaître leurs goûts préalables.

Mélange de Gaussiennes

- Une manière de trouver des groupes dans les données en supposant que chaque groupe suit une forme spécifique (une "cloche").

- Pratique pour regrouper des utilisateurs ou des objets similaires.

3. Les ensembles

Objectif : Améliorer la précision et la stabilité des prédictions.

Boosting

- Combine plusieurs modèles faibles (qui font des erreurs) pour créer un modèle puissant. Chaque modèle corrige les erreurs du précédent pour obtenir de meilleures prédictions.

- Exemple : Optimiser la sélection des publicités en ligne pour augmenter les clics et les ventes en combinant plusieurs modèles qui évaluent les performances des annonces.

Bagging (Bootstrap Aggregating)

- Combiner plusieurs modèles pour réduire la variance.

- Exemple typique : Random Forest.

Forêts d'arbres décisionnels

- Une méthode utilisant des arbres de décision (modèles simples) en les combinant pour faire des prédictions robustes.

4. Réseaux de neurones

Objectif : Trouver n’importe quelle fonction ou relation entre de « 1 à n variables prédites » et de « 1 à n variables explicatives ».

Multicouches (MLP : Multi-Layer Perceptron)

- Les neurones sont organisés en couches : une couche d'entrée, une ou plusieurs couches cachées, et une couche de sortie.

- Chaque neurone reçoit des données, les transforme (avec une "activation") et les transmet.

Réseaux à convolution (CNN)

- Utilisés pour traiter des images. Ils repèrent les motifs importants (ex. : bords, textures) en passant une "loupe" sur l'image.

- Exemple : Identifier des défauts dans des pièces industrielles sur une chaîne de production grâce à des images capturées par des caméras haute précision.

Réseaux récurrents (RNN)

- Conçus pour travailler avec des données séquentielles comme du texte ou de l'audio.

- Ils "se souviennent" des informations passées pour prédire les suivantes.

Réseaux non supervisés

- Ils découvrent des structures cachées sans labels.

- Exemple : Grouper des clients avec des comportements similaires.

GANs

- Deux réseaux s'affrontent : un générateur (crée des données) et un discriminateur (évalue si les données sont réalistes).

- Exemple : Créer des prototypes de produits en 3D pour des essais marketing ou générer des conceptions architecturales pour des clients.

Attention & transformers

- Techniques qui permettent aux modèles de se concentrer sur les parties importantes des données.

- Transformers : Modèles très performants pour le traitement du langage (comme GPT).

Modèles génératifs

- Produisent des données réalistes à partir de “rien” (ex. : texte, images, audio).

5. Aperçu de techniques avancées

Transfert d'entraînement

- Utiliser un modèle pré-entraîné pour résoudre un problème similaire.

- Exemple : Réutiliser un modèle formé pour reconnaître des chiens et chats, dans le but d’identifier d’autres races spécifiques.

Augmentation de données

- Créer artificiellement plus de données d'entraînement (ex. : retourner une image ou la recadrer).

- Exemple : Améliorer un modèle de reconnaissance faciale en générant des images légèrement modifiées (rotation, éclairage).

Normalisation

- Ajuster les données pour qu'elles soient dans une échelle cohérente, ce qui aide les modèles à apprendre efficacement.

Compression

- Réduire la taille d'un modèle (pour qu'il soit plus rapide) tout en gardant ses performances.

- Exemple : Réduire la taille d'un modèle pour l'exécuter efficacement sur un smartphone.

Convolutions dilatées

- Une extension des CNN pour capturer des détails à des échelles différentes.

Recherche d'hyperparamètres

- Trouver les meilleurs paramètres pour un modèle.

- Méthodes :

- Grille : Tester toutes les combinaisons possibles.

- Aléatoire : Tester des combinaisons au hasard.

- Bayésienne : Utiliser l'apprentissage pour choisir les meilleurs paramètres à tester.

- Exemple : Optimiser un modèle de recommandation pour un site d'e-commerce en testant différentes combinaisons de paramètres avec une recherche bayésienne.

6. Approche pour se lancer

Les règles du succès

↳ commencer par un objectif raisonnablement simple

↳ ajouter des fonctionnalités de bon sens sans ajouter de complexité

LA règle : n'ayez pas peur de lancer un produit sans machine learning.

- Le Machine Learning est puissant, mais nécessite des données et est coûteux.

- Mesurez précisément le problème que vous voulez résoudre, avec des métriques simples, pour valider la nécessité d’utiliser du ML. Choisissez une métrique business, qui vous guidera tout au long du projet.

- Pour un problème donné, si des heuristiques simples ont un résultat efficace, ça suffit. On ne passe au ML seulement si les heuristiques ne suffisent plus ou deviennent trop compliquées à gérer.

- Une heuristique est une règle simple, intuitive et approximative qui fonctionne suffisamment (du bon sens, finalement).

LE premier modèle

- Des données biaisées ou incomplètes amèneront les mêmes erreurs dans un modèle.

- Optez d’abord pour des modèles simples et interprétables : régression linéaire, arbres de décision…

- Commencez avec un prototype simple, imparfait mais fonctionnel. Testez et itérez rapidement.

- Transformer vos heuristiques qui fonctionnent bien en features pour enrichir vos données

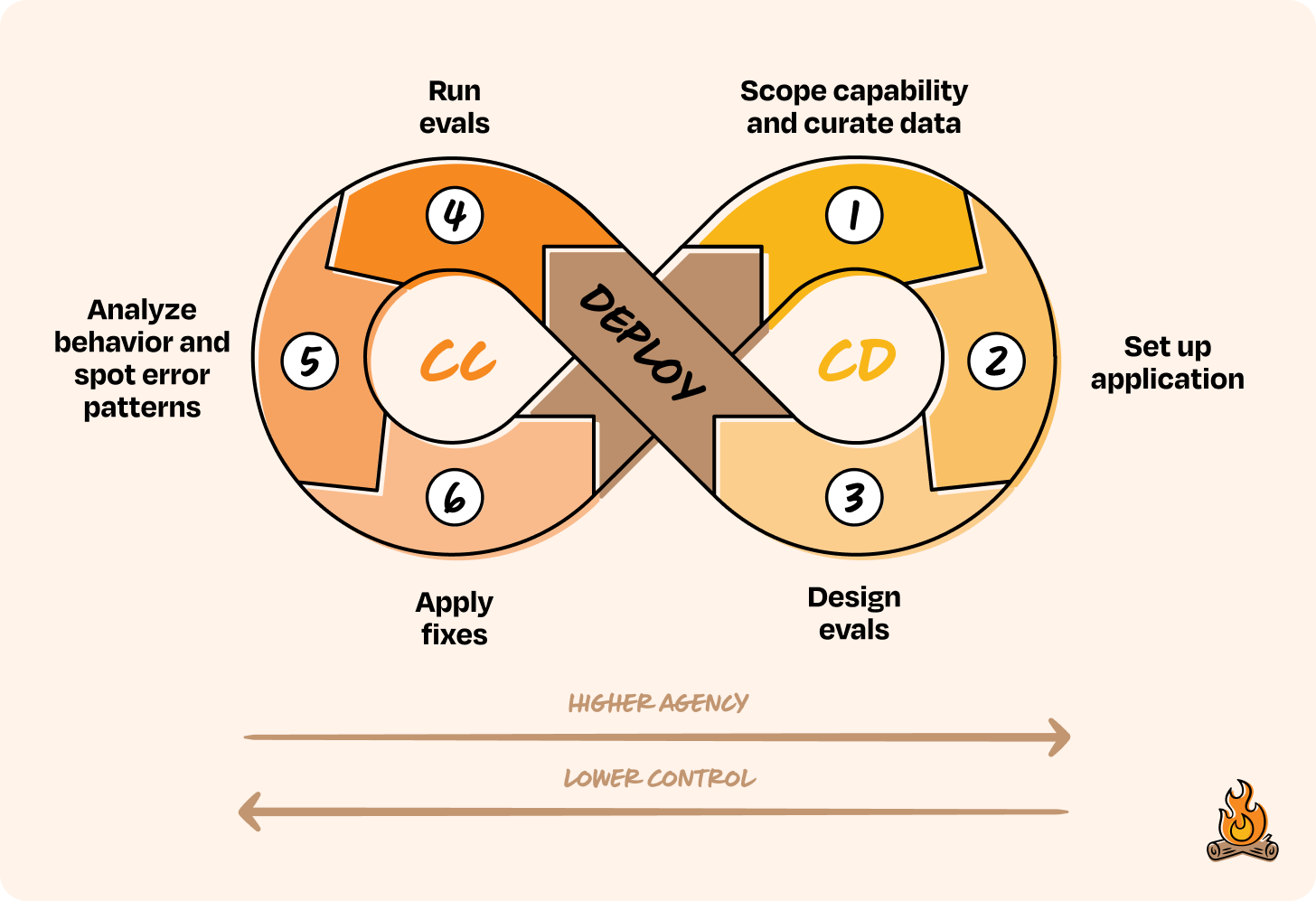

Les enjeux de la maintenance en IA

Ce n’est pas un projet tech classique !

Un système IA évolue constamment après son déploiement, car les données utilisées en production changent au fil du temps, rendant le modèle moins performant.

Par exemple, un modèle de recommandation peut devenir obsolète si les préférences des utilisateurs évoluent ou si de nouveaux types de produits apparaissent.

- Réutiliser le même code et enregistrez les caractéristiques des données en production pour identifier rapidement tout changement.

- Éviter de superposer plusieurs modèles (stacking), car cela complique le débogage et l’évolution.

- Miser sur de nouvelles données plutôt que sur des solutions artificielles (autant que possible).

- N’oubliez pas que votre modèle doit répondre aux besoins réels de l’entreprise, et gardez en tête votre métrique business. Personne ne doit être là pour optimiser uniquement des métriques techniques (ça arrive plus souvent qu’on ne le pense).

7. Et le deep learning, qu’est-ce que c’est ?

Le Deep Learning (DL) utilise des réseaux de neurones pour apprendre à résoudre des problèmes, en trouvant eux-mêmes les règles ou relations nécessaires pour accomplir une tâche, comme reconnaître un visage sur une photo ou traduire un texte. L’idée est de tenter d’approximer n’importe quelle fonction continue avec une somme de fonctions simples.

- Chaque neurone est composé d’une fonction linéaire dont le résultat de l’un est l’entrée du prochain neurone.

- Entre chaque neurone, une fonction d’activation permet d’ajouter de la complexité au réseau.

- Quand il y a plusieurs couches de neurones reliés entre eux, on dit que l’apprentissage est profond.

- Les circuits “feedforward”, comme ceux utilisés dans les LLMs (Large Language Models), fonctionnent en temps linéaire. La quantité de calcul nécessaire est directement proportionnelle à la taille du circuit. Plus le réseau est grand (avec plus de couches ou de neurones), plus le calcul sera long, mais cette augmentation est prévisible et suit une progression régulière.

Ressources pour aller plus loin

- 🎓 Cours gratuit :

- Introduction au ML à Standford : https://www.youtube.com/watch?v=Bl4Feh_Mjvo

- Introduction au ML par Google : https://developers.google.com/machine-learning/crash-course?hl=fr

- 📚 Livres disponibles sur arXiv :

- "Introduction to Machine Learning" by Laurent Younes

- "Machine Learning: The Basics" by Alexander Jung

- "A Brief Introduction to Machine Learning for Engineers" by Osvaldo Simeone

- 🛠 Outils utiles :

- Teachable Machine pour tester rapidement des modèles.

- Kaggle ou Hugging Face pour explorer des datasets et collaborer sur des projets ML.

Victor Galli (Kayro.ai)

➔ Linkedin / Prendre RDV

Envie de continuer votre lecture ?

Prêt à innover ?

Contactez-nous pour découvrir comment notre expertise en IA peut transformer votre entreprise